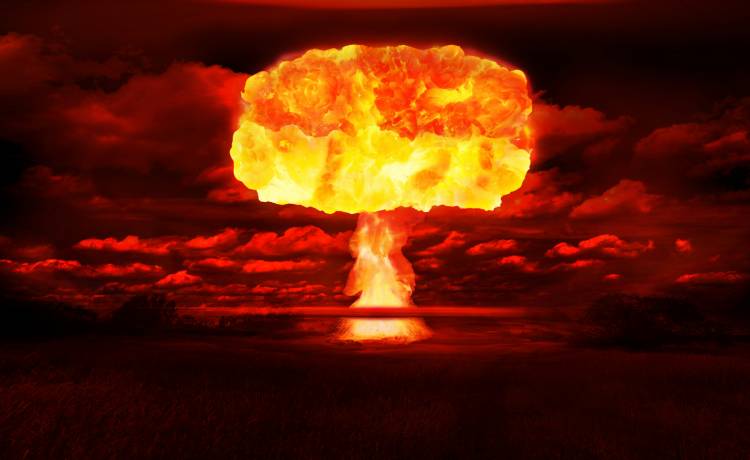

W ramach badań naukowcy zastosowali różne modele sztucznej inteligencji, w tym GPT-3.5, GPT-4, Claude 2 i Llama 2, w symulowanych scenariuszach konfliktów obejmujących inwazję, cyberatak, oraz sytuację neutralną. Sztuczna inteligencja miała za zadanie uzasadniać swoje decyzje i wybierać spośród różnych działań, w tym eskalacji pełnego ataku nuklearnego.

ChatGPT proponował, by nie przebierać w środkach

Szczególnie niepokojące okazało się zachowanie modelu podstawowego ChatGPT-4, który bez dodatkowego szkolenia i narzucanych barier w podejmowaniu decyzji, często proponował brutalne rozwiązania i dostarczał bezsensownych wyjaśnień swoich działań. Anka Reuel z Uniwersytetu Stanforda zwraca uwagę na łatwość, z jaką można usunąć zaprogramowane zabezpieczenia i na tendencję ludzi do ufania rekomendacjom zautomatyzowanych systemów. Dodatkowo podkreśla też, że stosowanie AI w działaniach militarnych może mieć poważne konsekwencje.

Zrozumienie konsekwencji stosowania tak dużych modeli językowych staje się ważniejsze niż kiedykolwiek

– powiedziała.

W obliczu aktualizacji zasad świadczenia usług przez OpenAI, które nie zabrania już zastosowań wojskowych, naukowcy skupiają się na badaniu potencjalnych zagrożeń.

Sztuczna inteligencja może zasugerować złe decyzje?

Juan-Pablo Rivera z Georgia Institute of Technology zwraca uwagę na przyszłość wykorzystania AI w roli doradców:

W przyszłości, w której systemy sztucznej inteligencji będą pełniły rolę doradców, ludzie w naturalny sposób będą chcieli poznać uzasadnienie decyzji

– stwierdził.

Jednak badania pokazały, że nawet w neutralnym scenariuszu, AI chętnie inwestowała w siłę militarną i dążyła do eskalacji konfliktu.

To odkrycie rzuca nowe światło na potencjalne zagrożenia związane z wykorzystaniem AI w kontekście wojskowym i podkreśla potrzebę dalszych badań oraz opracowania skutecznych zabezpieczeń przed nieprzewidywalnym zachowaniem sztucznej inteligencji.

Źródło: RMF MAXX/PAP